作为世界上第一个自我觉醒的机器人,电影《超能查派》中人工智能 “查派”却被教坏,逐渐成长为一个“杀人机器”。人工智能在未来真的会威胁到人类吗?人工智能可能蕴藏着什么危险? 5月4日,碁震KEEN公司创始人兼CEO,国际安全极客大赛GeekPwn创办人王琦在“造就”TALK上发表了关于《人“攻”智能》的演讲,从白帽黑客的视角带来了对未来人工智能安全的独到见解和预测。

(国际安全极客大赛GeekPwn活动创办人王琦)

AI看到了世界 黑客却看到了危险

几十年间,人工智能经历了一波三折的曲折发展,例如计算机视觉领域的图像识别,它的识别正确率一直难以取得大的突破,但是近年来取得了很多了不起的成果。2012年, Google X 实验室发出了一套具备自主学习能力的神经网络系统,不借助任何外界信息帮助,它就能从一千万张图片中找出那些有小猫的图片。如今,人工智能已经广泛应用于生活的诸多场景中,包括实时语音翻译、目标识别、自动驾驶、人脸识别、人机对话等等。王琦在感受到兴奋的同时,也表达了他的担忧:我们要关注到人工智能可能暴露出的诸多潜藏风险。

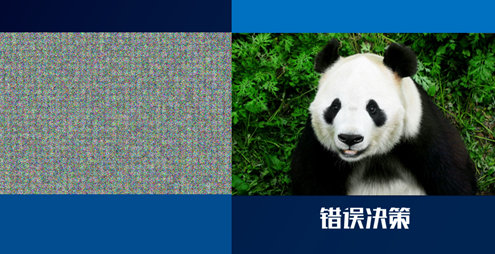

“如果能够让自动驾驶的图像识别产生错误判断,分不清楚前方遇到的是人还是树,我认为这就是黑掉了它,这可能要比黑掉传统的控制系统更酷。” 王琦说。GeekPwn实验室在2015年底开始了AI对抗的研究,并广泛接触和招募AI领域的顶尖人才,很快,在2016年的GeekPwn美国站上,生成对抗网络(GANs)之父Ian Goodfellow就展示了“对抗性图像”在现实物理世界欺骗机器学习的效果。原始图像以60%的置信度判断为“熊猫”,但是加入了微小的干扰,在人眼完全看不出差别的情况下却以99%的执行度归为了长臂猿。

加入干扰元素的图像引起AI的误判

AI学习和决策模型与黑客领域的漏洞挖掘和利用过程何其相似

AI在图像领域存在被欺骗的可能性,让王琦预见到这种可能性在其他语音和行为智能等领域也会存在。AI被欺骗,看似人工智能的错误和不完善,但其实在黑客眼里就有可能变成可以被利用的漏洞。“现代信息安全领域里的高级攻击利用的漏洞,在很多年以前都仅仅被看作是计算机错误。需要警惕的是,凡是错误,可能到了黑客那里就变成了安全漏洞。”王琦说。人工智能依赖对大量样本进行深度学习,最后产生决策的过程,和安全领域里通过产生大量模糊测试样本引发计算机异常从而发掘出漏洞,最终执行流程可以被改变导致安全危害的过程非常相似,如果说正确样本能够产生正确的决策,那么黑客通过离线模拟产生的AI攻击样本,则可能给人工智能带来错误的决策和行为。

微软聊天机器人Tay上线不到一天,就向网友“成功学习”了新的聊天方式,从彬彬有礼的美国“姑娘”变得脏话不断,言语中还充斥了种族主义、色情等“情感偏见”。王琦大胆预言:深度依赖学习样本的人工智能,未来对它的攻击可能甚至不需要编写代码,人人都可能成为“黑客”。

目前AI只有0.1岁 黑客能够帮助AI安全成长

白帽黑客从对抗的思路出发,寻找AI潜藏的风险并不断帮助其完善,其棒帮助人工智能安全健康成长。“对于人工智能的看法目前分为两派,悲观主义者认为人类研发人工智能可能是在自取灭亡,如果真的有那一天的话,白帽黑客可以做的是保护AI安全发展”王琦说。

当无人驾驶的“眼睛”被欺骗,它还能在马路上安全行驶吗?作为全球首个探讨人工智能和专业安全的前沿赛事平台,GeekPwn鼓励更多的白帽子黑客可以协助AI进行安全性的预演分析。将于5月12日在香港星梦邮轮“云顶梦号”上举办的极棒年中赛,就将针对人工智能的安全课题向全球黑客发出英雄帖。